#01 - ChatGPT, 4 mesures de cybersécurité à mettre en œuvre

Pas un jour sans voir de mauvais comportements liés à ChatGPT. Cet article vous partage notre vision et explique concrètement comment nous avons décidé d’aborder ce sujet dans les entreprises avec lesquelles nous travaillons.

Contexte

Une explosion de l’utilisation de chatgpt

Aujourd’hui, quasiment tout le monde utilise ChatGPT. Selon Sam Altman, PDG d’OpenAI, plus d'un milliard de personnes s'en servent régulièrement (conférence TED, 11 avril 2025). Dans notre quotidien professionnel, pas un jour ne passe sans croiser quelqu'un en train de l’utiliser. Même certains membres de notre équipe l'ont adopté. Avec une telle diffusion massive, une chose est certaine : en matière de cybersécurité, la scalabilité de cet outil va finir par nous retomber dessus lourdement.

Le Shawdow IT

Du point de vue cybersécurité, ChatGPT vient simplement s’ajouter à la longue liste du Shadow IT. D’après Gartner, ce Shadow IT représente déjà entre 30 et 40 % des dépenses informatiques dans les grandes entreprises. L’Everest Group appuie ces chiffres en révélant que seule la moitié des dépenses liées au cloud provient directement du budget de la DSI. Alors oui, ChatGPT s’est répandu très vite, mais soyons honnêtes : côté cybersécurité, même si au début on s’est tous dit que ça allait puer, c’est finalement juste un outil de plus à gérer dans un Shadow IT déjà bien chargé.

Les plugins

Là où ça devient franchement moins drôle côté cybersécurité, c’est quand ces outils ont commencé à proposer des plugins et des API ultra simples à utiliser. Prenez les GPTs personnalisés, par exemple : le GPT Store, qui a remplacé l’ancien système de plugins, héberge déjà plusieurs millions de GPTs créés directement par les utilisateurs; un chiffre atteint dès début 2024 et qui continue d’exploser. Résultat des courses ? On se retrouve avec un Shadow IT qui vient automatiquement se greffer sur le système d’information de l’entreprise. Autant vous dire qu’à partir de là, ça sent vraiment mauvais.

Problèmes

L’upload de documents

Le premier problème, côté cybersécurité, c’est évidemment l’upload de documents confidentiels, incluant des données sensibles, médicales ou personnelles, le tout sans aucun respect du RGPD. Très concrètement, les utilisateurs n'ont aujourd’hui aucun souci à exporter des bases de données internes pour les charger dans ChatGPT afin d'obtenir rapidement des analyses ou statistiques. On l'a vu récemment avec des exports massifs de logs provenant d’équipements critiques. Ce comportement pose clairement un problème majeur côté conformité RGPD, puisque ces uploads s’effectuent généralement depuis des comptes personnels ChatGPT. Autrement dit, l’entreprise perd totalement le contrôle de ses données sensibles. La question n’est donc plus « si » ça arrivera, mais comment stopper ce phénomène dès maintenant.

Les intégrations

Viennent ensuite ces fameux plugins et l’utilisation des API. En théorie, toute évolution du système d’information d’une entreprise impose une analyse des risques cyber, surtout quand des flux nouveaux apparaissent. Mais soyons réalistes : avec ChatGPT et ses intégrations en 10 secondes, le temps d’intercepter l’utilisateur pour instruire une analyse de risques, il est déjà trop tard. Cette réactivité nécessaire est totalement absente aujourd’hui. Or, ces analyses ne sont pas optionnelles ; elles sont désormais obligatoires pour garantir la conformité, notamment vis-à-vis de la directive NIS2. On se retrouve donc face à un risque majeur : des intégrations automatisées et invisibles, sans aucune maîtrise de la cybersécurité associée.

L’absence de stratégie claire

On nous demande maintenant de sensibiliser les collaborateurs sur l’utilisation de ChatGPT. En soi, c’est une excellente initiative. Mais attention à ne pas faire n’importe quoi : la sensibilisation ne doit pas seulement alerter, elle doit surtout encourager les utilisateurs à adopter de bonnes pratiques au quotidien. On revient ainsi aux règles d’or classiques de la cybersécurité : protéger les données, ne pas uploader d’informations sensibles, rester vigilant face aux risques. Le vrai problème, c’est que bien souvent, aucune stratégie claire et validée sur l’usage de l’intelligence artificielle n’a été établie par l’entreprise. Du coup, sensibiliser sans avoir fixé des règles précises, c’est juste ajouter du flou au flou.

Les mesures de sécurité

Voici un ensemble de mesures de sécurité que nous avons mis en œuvre et que nous vous partageons en retour d’expérience, à adapter forcement

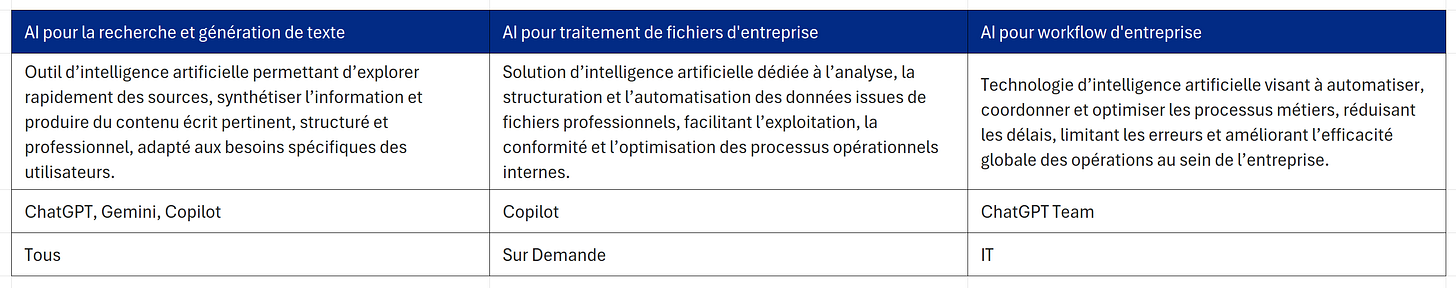

1 - La Matrice AI Entreprise

L’utilisation de ChatGPT ou de ses concurrents recouvre en réalité plusieurs cas d’usage distincts, et les règles d’encadrement doivent être adaptées spécifiquement à chacun d’eux. L’objectif est ainsi de formaliser clairement quels usages sont acceptés par l’entreprise, et d’associer à chaque usage un cadre précis. Concrètement, pour répondre à ce besoin, nous avons réalisé une matrice qui définit explicitement les règles à respecter selon trois grands types d’utilisation : l’usage pour la recherche et la génération d’idées, le traitement individuel de données propres à l’entreprise, et enfin le traitement automatique de flux de données dans une logique de performance collective.

Par exemple, dans cette matrice, les outils comme ChatGPT ou Gemini peuvent être autorisés pour toute l’entreprise dans un cadre de recherche générale. En revanche, le traitement de données internes n’est autorisé que via les licences Copilot réservées aux managers et aux profils nécessitant spécifiquement cette fonctionnalité. Enfin, l’utilisation automatisée via l’API officielle de ChatGPT est strictement limitée au compte professionnel géré par l’entreprise, afin d’en garantir le contrôle complet et la conformité.

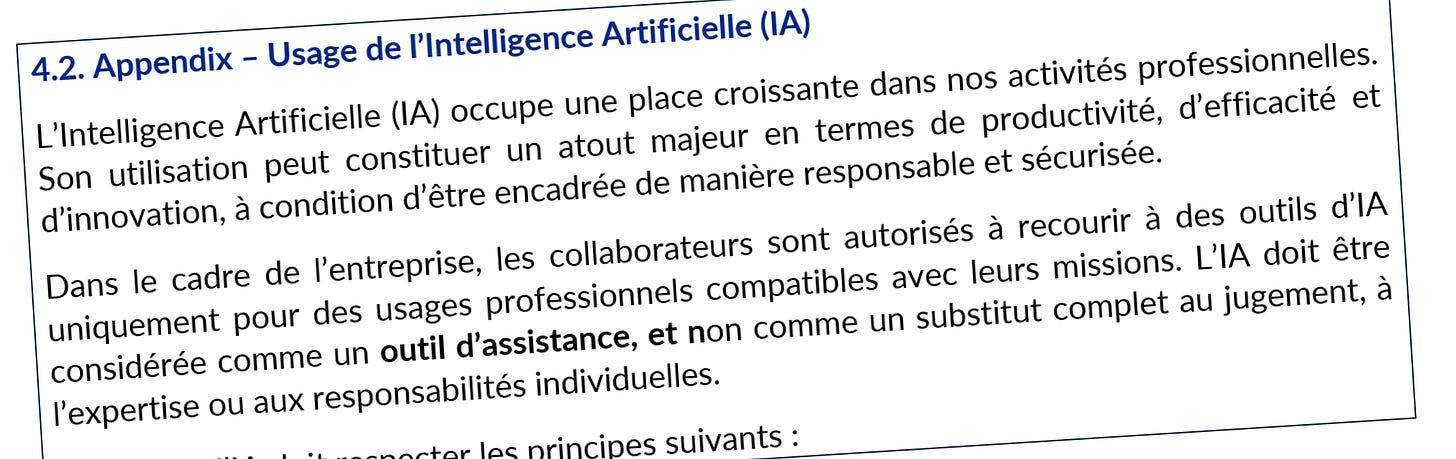

2 - L'Appendix Charte Informatique

Il est également essentiel de responsabiliser directement les utilisateurs concernant l’usage approprié des outils d’IA validés par l’organisation. En clair, l’objectif est que chaque utilisateur s’engage formellement à respecter les règles et consignes internes sur l’usage de l’intelligence artificielle.

Concrètement, cela peut passer par un document signé individuellement par chaque collaborateur, actant leur engagement à respecter ces directives.

Dans notre expérience avec les DSI avec qui nous avons traité ce sujet, la solution retenue a souvent été de créer un simple appendix dédié à l’utilisation de l’IA, directement intégré à la charte informatique existante. Cet ajout permet de clarifier très rapidement les règles attendues, d’assurer une cohérence avec les autres politiques internes déjà en place, et surtout de responsabiliser explicitement les utilisateurs.

3 - le Renvoie forcé ver le bon outil

Quand l’organisation a mis en place des règles claires sur l’usage de l’IA et impose un outil en particulier, il est essentiel de vérifier que les utilisateurs respectent bien ces règles. En effet, il est tout à fait naturel que certaines personnes habituées à un outil précis préfèrent continuer à l'utiliser par confort ou habitude.

L’idée est donc simple : accompagner techniquement les utilisateurs vers l’outil choisi et validé par l’organisation. Concrètement, il existe plusieurs moyens techniques pour effectuer ce « renvoi » : souvent, cela passe par la redirection automatique d’une requête utilisateur vers l’outil officiel.

Par exemple, lorsqu’un utilisateur tente d’utiliser Gemini alors que l’organisation a validé Copilot, la requête peut être interceptée et réorientée automatiquement. Nous avons déjà réalisé ce type de redirection chez un client via la solution Netskope, en renvoyant les utilisateurs qui tentaient d’accéder à ChatGPT vers Copilot.

Évidemment, ce genre de solution doit s’adresser à un public averti, conscient du cadre imposé.

4 - Une sensibilisation dédiée

Pour garantir sécurité et confidentialité, il est essentiel d’expliquer modestement aux équipes les règles de la matrice cyber AI. Ainsi, chacun comprend vraiment et respecte les limites d’usage de ChatGPT.

Pour garantir une utilisation responsable de ChatGPT, un deck de sensibilisation doit être conçu : exposer les risques (fuites, attaques), rappeler les exigences cyber de l’entreprise, illustrer des cas réels d’incidents, détailler les menaces spécifiques et proposer des mises en situation pratiques. Cette démarche ancre durablement aux collaborateurs les bonnes pratiques.

Nous avons eu le cas par exemple, d’une société qui a défini Copilot comme l’outil principal pour ses collaborateurs pour traiter les données d’entreprise. Bien qu’il y a des limites, c’est l’outil principal qui a été décidé. Enfin pour des questions de coût, pour les usages d’amélioration de performance de process d’entreprise, là c’est l’outil ChatGPT entreprise qui a été utilisé, avec l’utilisation d’un DPA spécifique pour ce scénario. Dans ce contexte, il a été rappelé de l’obligation de faire une analyse de risques cybersécurité.

RESSOURCES CYBERLEAD

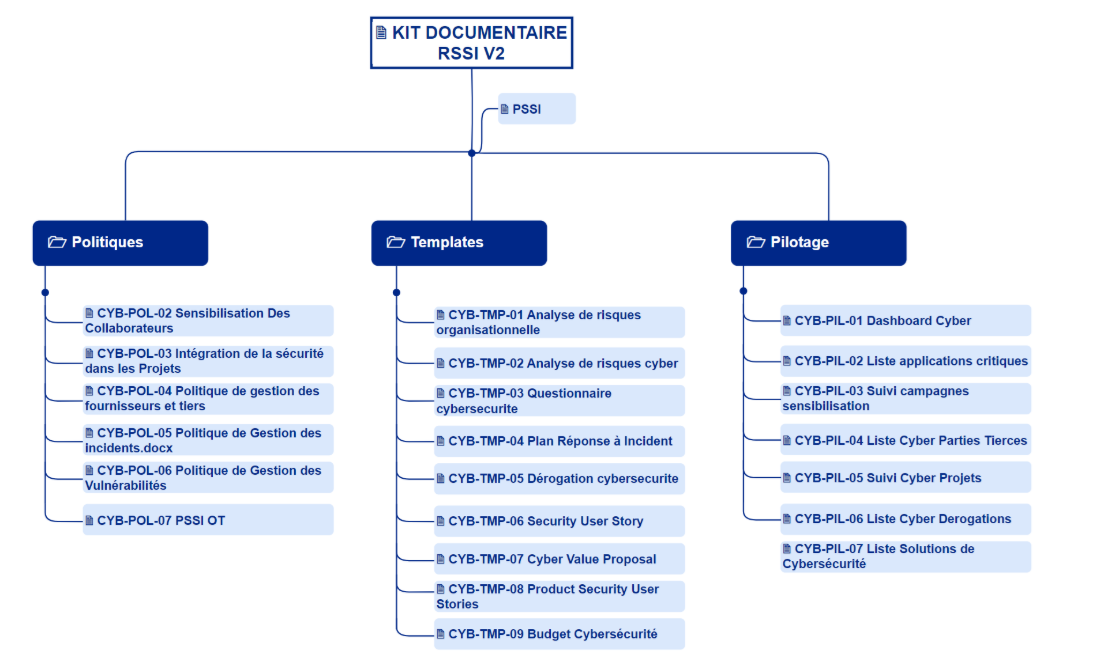

KIT DOCUMENTAIRE RSSI

Nous partageons avec notre communauté un ensemble de templates prêts à l’emploi pour structurer et piloter efficacement la cybersécurité de votre organisation : PSSI, gestion des dérogations, questionnaires fournisseurs, inventaire des applications critiques, analyses de risques flash, dashboards, PCA/PCI, et plans d’action incidents.