[Alerte] Incident de sécurité sur notre infrastructure

Retour terrain d'une alerte de sécurité reçu d'un fournisseur

Contexte :

Une entreprise du secteur industriel, organisée autour de plusieurs sites de production, de plateformes logistiques et d’une flotte de camions. L’activité repose sur une coordination fine entre fabrication, transport et distribution. Chaque site fonctionne avec ses propres outils, souvent anciens, et la communication entre les différents environnements reste partielle, parfois encore très manuelle.

L’entreprise travaille avec de nombreux fournisseurs connectés à son système d’information. Parmi eux, les prestataires du WMS et du TMS, essentiels pour la gestion des stocks et des flux de transport. Ces interconnexions assurent la fluidité opérationnelle, mais multiplient aussi les points d’entrée potentiels dans le réseau, souvent sans gouvernance de sécurité clairement établie.

Une alerte de sécurité nous parvient via le service achats. Elle concerne notre prestataire de télémaintenance, en charge de la supervision des systèmes liés au transport. Le message reste mesuré, sans détails techniques, mais il évoque un incident de sécurité confirmé chez le fournisseur. L’information circule rapidement en interne, entre la DSI, les achats et les équipes transport.

Problème

Le fournisseur concerné fait partie des partenaires critiques de l’entreprise. Son rôle est central dans la continuité des opérations : s’il s’arrête, tout s’arrête. Les flux de transport, la maintenance et la coordination logistique dépendent directement de ses systèmes. Cette dépendance est connue, assumée, mais rarement formalisée. L’incident rappelle brutalement qu’une fragilité externe peut immobiliser toute la chaîne industrielle.

La connaissance technique du fournisseur reste limitée. Les échanges passés ont souvent montré des approximations, des retards et un certain manque de rigueur dans la gestion des accès et des mises à jour. Des tensions existaient déjà depuis plusieurs mois. L’incident n’a donc surpris personne : on savait que la situation finirait par déraper. Ce n’était qu’une question de temps avant que le problème ne se concrétise.

En pratique, la sensibilisation interne sur le risque de propagation venant des fournisseurs reste faible. Beaucoup considèrent encore qu’un incident externe ne peut pas vraiment impacter l’entreprise. Le sujet paraît théorique. L’idée dominante : les firewalls bloquent les ransomwares, donc le risque est contenu. Une confiance parfois excessive dans les protections périmétriques, perçues comme une barrière absolue.

En pratique

Vérification de l’information auprès du fournisseur

La vérification de l’information a été compliquée dès le départ. Le fournisseur a envoyé un simple courriel pour signaler l’incident, sans détail technique ni indication claire d’impact. Impossible ensuite de joindre quelqu’un. Le RSSI est “occupé”, les réponses arrivent au compte-gouttes. Pendant deux jours, un flou complet : aucune confirmation, aucune position officielle. Le discours oral se veut rassurant : “vous n’êtes pas concernés”, mais rien n’est formalisé. L’absence d’écrit entretient l’incertitude et empêche toute évaluation sérieuse du risque réel.

Vérification de tous les liens réseaux et flux avec le fournisseur

La vérification des liens réseaux avec le fournisseur tourne vite au casse-tête. Le responsable réseau dispose bien de la liste des interconnexions, mais impossible de préciser les flux réels en circulation. Certains semblent passer “en dépannage”, même après coupure des liens officiels. Les échanges sont confus, la documentation inexistante. On lance une chasse aux flux, entre anciens schémas, tickets et souvenirs. Côté fournisseur, silence radio : les équipes sont absorbées par la gestion de leur propre incident. L’incertitude persiste, et chaque découverte soulève plus de questions que de réponses.

Coupure de tous les liens

Face à l’absence de communication claire et aux doutes persistants, la décision s’impose : couper tous les liens. En pratique, ce “on décide” a été un véritable challenge. Personne ne voulait assumer seul la responsabilité. La discussion s’est tenue en cellule de crise, dans une tension palpable. Après plusieurs échanges, la décision est finalement prise collectivement. Ma recommandation de tout couper est suivie. Un choix prudent, mais nécessaire, validé par consensus plus que par conviction.

Vérification en mode investigation sur tout les assets connectés au réseau du fournisseur

Une phase d’investigation est lancée pour vérifier tous les assets susceptibles d’être connectés au réseau du fournisseur. L’objectif : identifier où les flux pouvaient aboutir et s’assurer qu’aucune activité suspecte n’a été détectée. Les équipes passent en revue chaque point de connexion, en se concentrant particulièrement sur les exceptions, souvent les angles morts du réseau. Les logs sont analysés, les comportements comparés à la normale. Rien d’anormal, mais la vigilance reste maximale.

Demande formelle du retour au bon fonctionnement de la part du fournisseur

Avec l’appui du service juridique, une demande formelle est rédigée à destination du fournisseur. L’objectif est clair : obtenir une confirmation écrite du retour à un fonctionnement normal avant toute reconnexion. Le ton reste mesuré, sans chercher à accuser. Lors des échanges, nous expliquons la démarche : il ne s’agit pas de méfiance, mais de responsabilité. Nous devons prouver notre diligence, tant vis-à-vis de nos clients que des autorités. Une étape administrative, mais essentielle pour encadrer la reprise.

Recommandations

Garder son calme, même face à un fournisseur peu communiquant

Garder son calme, même face à un fournisseur peu communicant, est essentiel. La frustration est naturelle, surtout quand les réponses manquent. Mais il faut se rappeler que le fournisseur n’a pas forcément l’expérience d’une crise cyber. L’objectif, c’est le résultat, pas le reproche. Les règlements de compte viendront plus tard, une fois la situation maîtrisée. Dans ces moments, le calme reste la meilleure arme pour avancer efficacement.

Récupérer les éléments techniques de manière formel écrite

Récupérer les éléments techniques de manière formelle et écrite est une discipline essentielle. Dans l’urgence, on s’appuie souvent sur des échanges oraux, rapides, parfois approximatifs. Mais ces informations peuvent être inexactes, voire contradictoires. Dans une situation où chaque décision compte, seuls les faits vérifiables permettent d’agir sereinement. L’écrit protège, clarifie et trace. C’est la base d’une gestion de crise maîtrisée et défendable.

Réagir de manière proportionnelle

Réagir de manière proportionnelle, c’est sans doute le plus difficile. L’adrénaline monte vite en situation de crise, et la peur de mal faire pousse parfois à sur-réagir. On sait tous qu’un RSSI peut être fragilisé après une gestion imparfaite, mais il faut savoir garder le recul nécessaire. Agir de façon mesurée, posée, quitte à ajouter les bons disclaimers, reste la meilleure manière d’avancer sans céder à la panique.

Etendre le SOC aux flux avec les fournisseurs

Étendre la surveillance du SOC aux flux avec les fournisseurs aurait clairement fait gagner du temps. Si ces connexions avaient été intégrées dès le départ dans le périmètre de supervision, l’investigation aurait été plus rapide et plus précise. Les signaux faibles auraient été détectés plus tôt, et la coupure totale des liens, probablement évitée. C’est un apprentissage concret : surveiller les interfaces critiques, pas seulement l’interne.

Conclusion

Un ransomware chez un fournisseur, c’est devenu un grand classique. Mais le jour où ça tombe, la difficulté, c’est de gérer sans laisser les émotions prendre le dessus. Garder la tête froide, poser les bons gestes, et ne pas ajouter de chaos à la crise, c’est là tout l’enjeu.

On le sait, les attaques par la supply chain se multiplient. Il faut absolument anticiper ces scénarios avant qu’ils ne deviennent des urgences. Identifier les dépendances critiques, connaître ses fournisseurs et leurs interconnexions, c’est une base de survie. Le risque n’est plus théorique, il fait désormais partie du quotidien opérationnel.

Ressources CyberLead

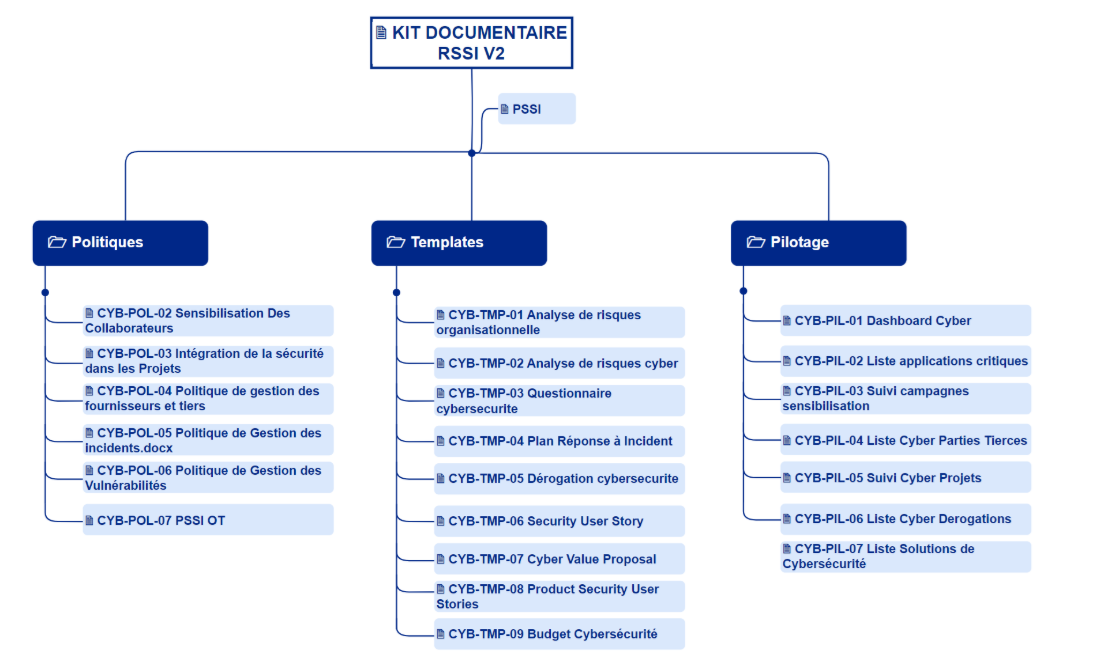

Afin de faire connaitre CyberLead, dont je suis le CEO , j’ai conçu le Kit RSSI avec un ensemble de templates et documents issus de mon expérience de RSSI dans des structures de différentes tailles et différentes maturités :

CVTHEQUE CYBERLEAD

Pour être efficace en cybersécurité il faut surtout les bonnes personnes au bon endroit. C’est pour cela que je lance la CVthèque Cyberlead dédiée à la cybersécurité. Celle-ci a pour but de connecter les candidats et les recruteurs au moyen de fiches standardisées, de tags de compétences, de niveaux d’expérience, de la localisation et de la disponibilité.

A la recherche d’une nouvelle opportunité ?

REX CYBERLEAD

Il y a quelques temps j’ai accompagné une structure dans le cadre d’attaque d’une ligne de métro. Aujourd’hui j’ai décidé de proposer un atelier pour partager avec vous un REX anonymisé “Décontamination d’une ligne de métro”. Ce REX est exclusivement réalisé sur site.

Pour des raisons de confidentialité et de criticité, ce REX est réservé exclusivement à destination des clients finaux comportant des infrastructures critiques .

Dans le cadre de cet atelier je vous présenterai :

Le contexte d’un OT hétérogène soumis à de fortes contraintes d’exploitation et marqué par des dépendances IT↔OT

La restitution de l’historique avec une vision globale et structurée de la situation.

Les résultats que j’ai obtenu ainsi que les leçons tirés directement de la situation de crise.

Les recommandations définies et applicables directement sur le terrain.

Riche retour d'expérience cela fait plaisir à lire d'être plongé dans un incident réaliste.

Donc pas de compromission sur votre SI mais une déconnexion à titre préventive n'est-ce pas ?